Zillow es uno de los sitios web más populares utilizados para buscar viviendas, comprobar su valor y encontrar agentes inmobiliarios. También tiene muchos datos sobre las viviendas locales, sus precios y los agentes inmobiliarios. Es por eso que el raspado de datos de Zillow es ideal para utilizar en sus herramientas y aplicaciones de terceros para las necesidades comerciales de bienes raíces.

En la siguiente parte, usted puede aprender acerca de cómo extraer datos de Zillow fácil y rápidamente con un no-codificación Zillow raspador de datos.

¿Se Pueden Extraer Datos de Zillow?

El scraping de Zillow para obtener información inmobiliaria es una de las últimas tendencias en la compra de viviendas, y puede darte una ventaja competitiva si se utiliza con prudencia. Antes de lanzarse a Zillow, hay normas que debe seguir al hacer scraping en ese sitio web para no violar ningún límite ético o legal. El web scraping de los datos disponibles en la pantalla cuando buscas casas en una ubicación geográfica no es ilegal.

La información está disponible para cualquiera que tenga acceso a Internet y pueda ver el sitio web en un navegador. Zillow ha facilitado el uso de sus datos también a través de su propia API. Esto facilita la integración comercial con el grupo Zillow en el mercado inmobiliario. El uso de la API de Zillow es la mejor manera de acceder a la información comercialmente sin violar la ética y las políticas de Zillow.

Los datos que puedes extraer de Zillow contienen información sobre la lista de casas en venta en cualquier ciudad de su base de datos, incluyendo direcciones, número de dormitorios, número de baños, precio y mucho más. Los datos extraídos se pueden exportar en varios formatos como .csv, .txt, .xlsx, y su propia base de datos.

¿Cómo Raspar Zillow sin Código?

En esta parte, le diremos cómo raspar datos de Zillow sin ningún tipo de codificación. El objetivo es obtener detalles de la dirección, el precio, el nombre del anuncio, el agente inmobiliario asignado, y toda la información disponible para ver en el sitio web. Para ello, vamos a utilizar la herramienta de raspado web, Octoparse.

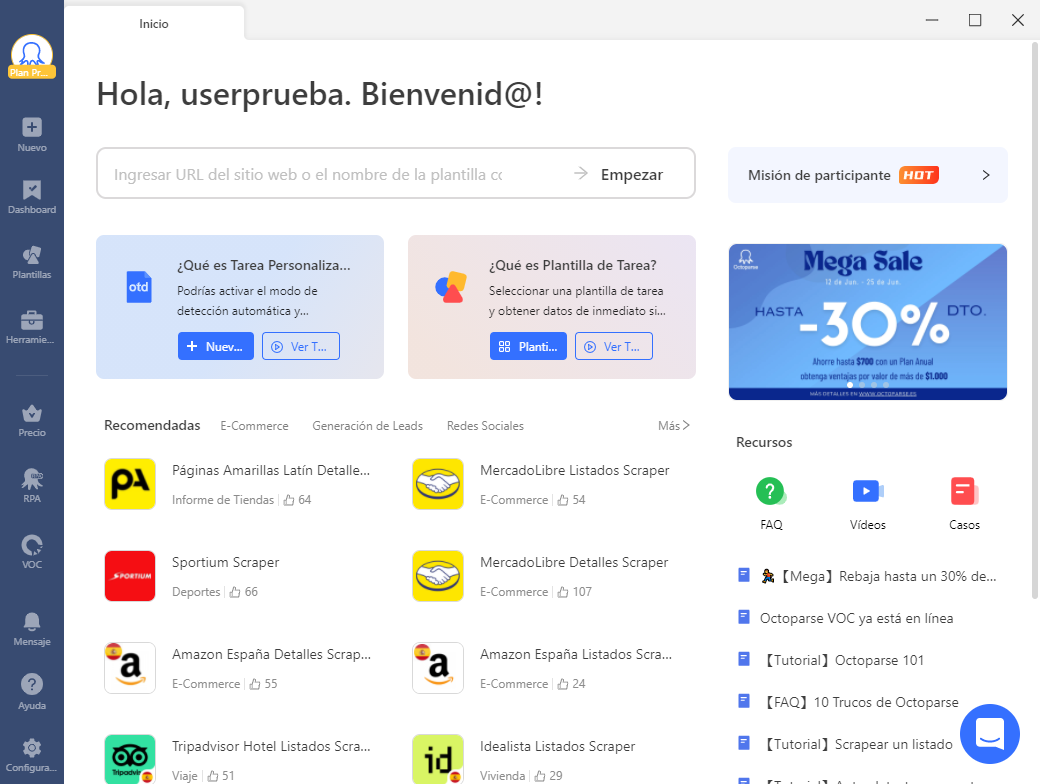

Octoparse es una popular herramienta de raspado web muy utilizada para el raspado de datos en sitios web. Puede detectar automáticamente datos como imágenes, páginas y listas en páginas web tan pronto como se abren en el navegador incorporado. Con esto, puede extraer los datos de varias páginas y descargar hasta 10.000 enlaces a la vez.

Octoparse también proporciona una plantilla de raspado preestablecida para obtener datos de listados de propiedades de Zillow en cuestión de clics. Puede utilizar directamente la plantilla en línea de raspado de datos de Zillow que se muestra a continuación introduciendo sólo unos pocos parámetros.

3 Pasos para Extraer Datos Inmobiliarios de Zillow Fácilmente

Para empezar, necesitas descargar e instalar Octoparse en tu dispositivo, y registrarte para obtener una cuenta gratuita si eres un nuevo usuario. A continuación, sigue estos sencillos pasos para empezar a extraer datos de Zillow.

Paso 1: Pegue el enlace de la página de Zillow en Octoparse

Copie la URL que necesita raspar de Zillow, y péguela en el cuadro de búsqueda de Octoparse. Haga clic en el botón Inicio para entrar en el modo de detección automática por defecto.

Paso 2: Crear un rastreador de datos de Zillow

Haga clic en el botón Crear flujo de trabajo después de la detección rápida. Puede realizar cambios en los campos de datos con las indicaciones del panel Consejos.

Paso 3: Extraer y descargar datos de Zillow

En la parte inferior de la pantalla, puede observar que la vista previa de los datos a extraer se muestra en formato de tabla. Comprueba si contiene todos los datos necesarios. Si no es así, simplemente seleccione los datos que necesita y se añadirán a una nueva columna. Los nombres de los campos pueden renombrarse seleccionándolos de la lista predefinida o introduciéndolos por su cuenta.

Haga clic en el botón Ejecutar para iniciar la tarea de extracción de datos en su dispositivo. Una vez completada la tarea, puede exportarla a su sistema local según el formato que desee.

También puede seguir los mismos pasos para obtener datos de otros sitios inmobiliarios populares como idealista.com, o puede leer el artículo Cómo Raspar Datos Inmobiliarios de Idealista en Python

Zillow Web Scraping con Python

Zillow tiene uno de los mayores volúmenes de datos entre los principales sitios web de listados inmobiliarios. Raspar sus datos puede ser de gran utilidad para los agentes inmobiliarios u otras personas con un interés comercial en los listados. Varios módulos y métodos creados con Python han facilitado el scraping web. Algunos de los paquetes que se utilizan ampliamente en el web scraping de datos son Beautiful Soup, Mechanical Soup, Selenium, Scrapy, etc.

En la siguiente parte, vamos a utilizar Beautiful Soup para raspar datos de Zillow. Abre cualquier IDE de Python. Ejecuta el siguiente código. Yo he utilizado PyCharm aquí.

# coding: utf-8

# Web scraping Zillow

# import request module

import requests from bs4

import BeautifulSoup as soup

header = {'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64)

AppleWebKit/537.36 (KHTML, like Gecko)

Chrome/83.0.4103.97 Safari/537.36',

'referer':'https://www.zillow.com/homes/for_rent/Manhattan,-New-York,-NY_rb/?searchQueryState=%7B%22pagination'

}

# Enter Zillow URL for the city of your preference

url = 'https://www.zillow.com/homes/for_rent/Manhattan,-New-York,-NY_rb'

html = requests.get(url=url,headers=header)

Html.status_code

bsobj = soup(html.content,'lxml') #bsobj - Beautiful Soup Object

bsobj

# price list is a list variable that will contain

# the price information.

price_list = []

# loop through the price section of the data and extract

# the text and store it in the list.

for price in bsobj.findAll('div',{'class':'list-card-heading'}):

print('price is: ',price.text.replace( 'bd','b|' ).replace(

'|s','|' ).replace('io','io|').strip().split('|')[:-1])

price_list.append(price.text.replace('bd','b|').replace('|s','|').replace('o','o|').strip().split('|')[:-1])

print(price_list)

# address list is a list variable that will

# contain the address information.

address = []

# loop through the address section of the data

# and extract the text and store it in the list.

for adr in bsobj.findAll('div',{'class':'list-card-info'}):

address.append(adr.a.text.strip())

print(address)

import pandas as pd

# create a pandas data-frame to store the address

# and price information.

df = pd.DataFrame( price_list,columns = ['Price1','Price2','Price3','Price4'] )

df['Address'] = address

print(df)El marco de datos pandas ‘df’ contiene información sobre los listados presentes en Manhattan, Nueva York. Este programa contiene bucles para extraer el precio y la dirección de las casas listadas. Puede ampliarlo extrayendo otros datos como el número de dormitorios, baños, etc. Puede guardarlo como un archivo CSV localmente en su sistema utilizando la función: df.to_csv(‘file_path’). Introduzca la ruta del archivo CSV junto con el nombre del archivo en lugar de file_path.

Reflexiones finales

El panorama inmobiliario digital está cambiando rápidamente, con la aparición de nuevos servicios y herramientas casi a diario. Zillow ha seguido creciendo significativamente en los últimos años, convirtiéndose en uno de los mayores sitios web y servicios inmobiliarios del mundo. El principal modelo de negocio de la empresa se centra en proporcionar a los usuarios información sobre viviendas en venta, tendencias del mercado inmobiliario y otros datos relacionados.

Ahora que ha aprendido los conceptos básicos de cómo hacer web scrape de datos, el siguiente paso sería generar ideas para dar un buen uso a la información raspada. Explore más de las características de Octoparse y otros métodos de python web scraping para ampliar su comprensión y fluidez en la recopilación de información mediante web scraping.

Convetir datos de sitios web en Excel, CSV, Google Sheets y base de datos directamente.

Scrapear datos fácilmente con funciones de Auto-Detectar, sin codificación.

Plantillas de crawler preestablecidas para sitios web populares para obtener datos en clics.

Nunca se bloquee con proxies IP y API avanzada.

Servicio en la Nube para programar la recopilación de datos en cualquier momento que desee.